سلام . من درس شبکه رو نگذروندم الان دارم خودم می خونم

تو بخش multi layer perceptron یه قسمت هست که گرادیان محلی(local gradient) رو برای لایه های مخفی پیدا می کنه ( همون جایی که خطا رو حساب می کنه و از روش مقدار تغییرات وزنها رو حساب می کنه) توی فرمول مربوط به لایه های مخفی معنی این سیگما رو نمی دونم چیه

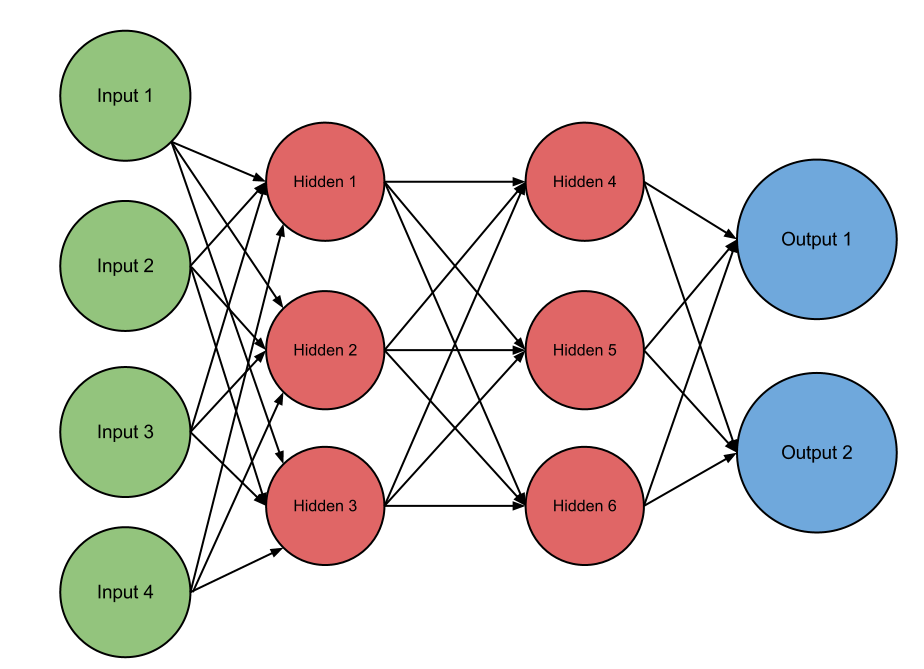

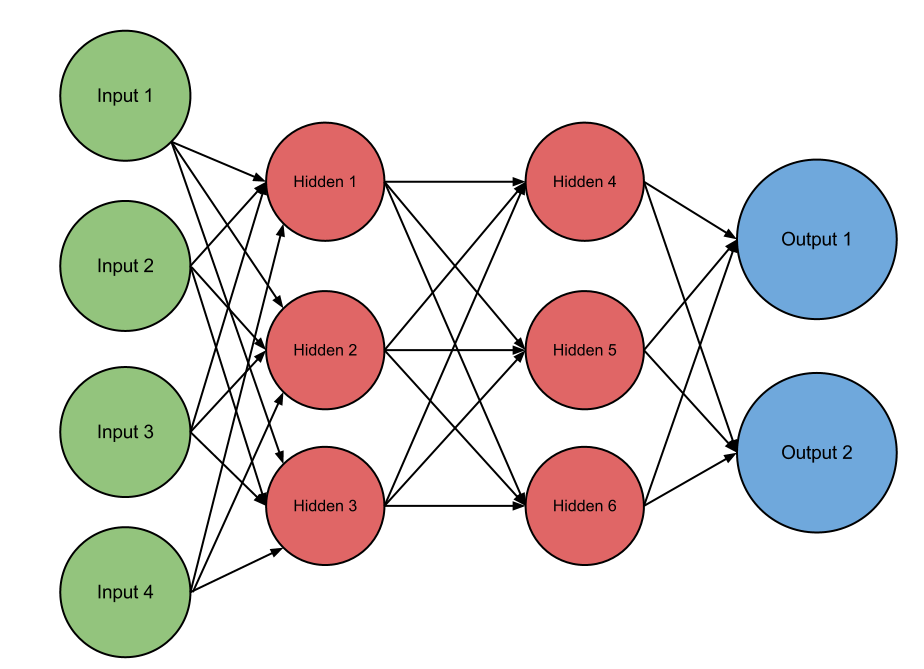

مثلا اگه دو لایه مخفی داشته باشیم مثل شکل زیر ، این فرمول دلتا برای دو لایه مخفی چی میشه ( منظورم اینه که سیگما باز بشه)

ممنون میشم راهنماییم کنید

تو بخش multi layer perceptron یه قسمت هست که گرادیان محلی(local gradient) رو برای لایه های مخفی پیدا می کنه ( همون جایی که خطا رو حساب می کنه و از روش مقدار تغییرات وزنها رو حساب می کنه) توی فرمول مربوط به لایه های مخفی معنی این سیگما رو نمی دونم چیه

مثلا اگه دو لایه مخفی داشته باشیم مثل شکل زیر ، این فرمول دلتا برای دو لایه مخفی چی میشه ( منظورم اینه که سیگما باز بشه)

ممنون میشم راهنماییم کنید

دیدگاه